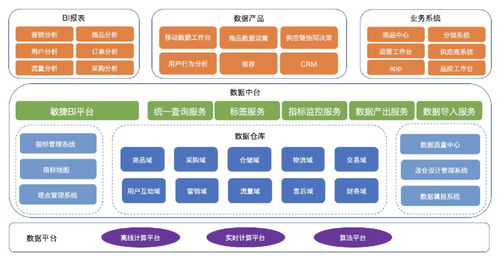

无限推荐系统承载了腾讯PCG(平台与内容集团)的推荐场景,包括:腾讯看店(浏览器、QQ看店、商业化)、腾讯新闻、腾讯视频、腾讯音乐、阅文、App Store、小拼拼等。无量推荐系统支持数亿日活跃用户,上千种车型,日均服务调用量达千亿。无限推荐系统可以在模型训练和推理中对海量Embedding和DNN模型进行GPU计算。是目前业界领先的架构设计。

传统推荐系统面临挑战

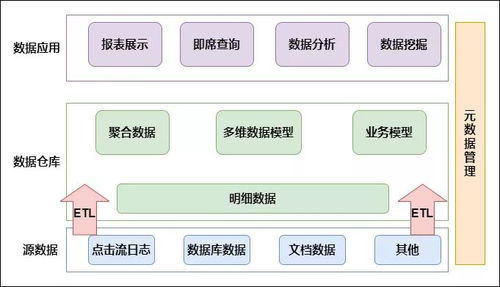

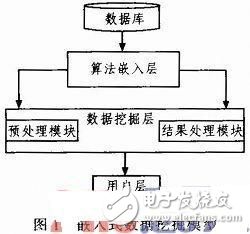

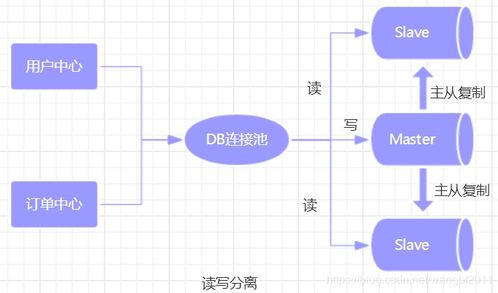

传统的推荐系统有以下特点: 训练基于参数服务器的框架,解决了海量数据、稀疏特征的分布式训练问题。 Inference通常将大规模Embedding和DNN分开,只能进行DNN的GPU加速。因此,传统的推荐系统架构存在一定的局限性: 1.大规模的分布式架构有很多额外的开销,比如网络参数和梯度的发送和接收。 2. 随着DNN模型的复杂度进一步增加,CPU的计算速度开始捉襟见肘。随着业务的快速增长,日活跃用户数快速增加,调用量快速增加,这给推荐系统后端带来了新的挑战: 1. 模型更加复杂,调用量增加计算量较大,但参数服务器的分布式架构,有效计算比例很低。 2. 由于海量Embedding规模巨大,查询和聚合计算很难有效利用高性能GPU内存和计算能力。

GPU 有助于提高模型训练和推理成本效益

基于以上挑战,腾讯PCG(平台与内容事业群)选择采用基于NVIDIA A100 GPU的分布式系统架构来打造无限推荐系统。

1.通过多级存储和Pipeline优化,在HPC上完成大规模推荐模型的高性能GPU训练。 2、基于特征访问幂律分布的特点,GPU缓存高频特征参数,并动态从CPU获取低频特征参数,实现大规模推荐模型的完整GPU端到端模型推理。

腾讯PCG拥有多种类型的推荐业务场景。比如消息流推荐的QQ浏览器、新闻推荐的QQ观看、腾讯新闻、视频推荐的腾讯视频、微视、App推荐的App、腾讯音乐推荐的音乐、阅文文学推荐等。

无量推荐系统承载着针对这些推荐业务场景的模型训练和推理服务。基于传统推荐系统架构,无量推荐系统占用大量CPU资源,通过分布式架构可以扩展到TB级模型的训练和部署,取得了巨大成功。随着业务的快速增长,日活跃用户数快速增长,通话量快速增长。传统架构的局限性限制了推荐系统的架构扩展和性能提升。

通过使用GPU训练和推理,单台多卡机器的GPU计算能力可以达到数十台CPU机器的计算能力,节省大量额外的分配开销。通过充分利用A100 GPU的高性能内存快速访问Embedding和并行计算能力来处理DNN推理,单个A100 GPU可以在相同延迟下推理10倍于CPU的评分样本。目前推荐的基于GPU的架构可以将模型训练和推理的成本效益提高1到3倍。

未来,无量推荐系统将持续优化推荐模型在GPU上的应用,利用HPC多机、多卡、混合精度等能力,进一步提高GPU在推荐场景中的使用性价比。

重的!快速浏览 NVIDIA 行业微型网站!内容涵盖了NVIDIA 12大行业解决方案,以及NVIDIA目前的重点产品资讯。

责任编辑:haq

-->